본 게시물은 CloudNet@에서 진행하는 AEWS (Amazon EKS Workshop Study) 스터디에 참여하며 정리한 내용입니다.

어느덧 AEWS 마지막 스터디 파트에 왔다. 인프라를 코드라는 관점에서 바라보고 관리한다는 Infrastructure as Code를 줄여 부르는 IaC를 EKS에 적용하는 부분에 대한 스터디이다. 이 스터디에서는 Terraform을 사용한다.

Terraform은 Hashicorp 회사에서 공개한 오픈 소스로, 2023년 8월 경에 MPL (Mozilla Public License)에서 BSL (Business Source License)로 변경이 이루어졌다 (관련 정보: Hashicorp 홈페이지 - License FAQ 영문 사이트 링크). HashiCorp Configuration Language에 따라 인프라를 코드 형태로 작성하면 계획 (plan) 후 적용 (apply)하는 방식으로 동작이 이루어진다.

0. 실습 환경 배포 & 소개

WSL2에서 동작하는 Ubuntu 20.04 LTS 환경에서 실습을 진행하였다.

wget -O- https://apt.releases.hashicorp.com/gpg | sudo gpg --dearmor -o /usr/share/keyrings/hashicorp-archive-keyring.gpg

echo "deb [signed-by=/usr/share/keyrings/hashicorp-archive-keyring.gpg] https://apt.releases.hashicorp.com $(lsb_release -cs) main" | sudo tee /etc/apt/sources.list.d/hashicorp.list

sudo apt update && sudo apt install terraform

# 테라폼 버전 정보 확인

terraform version

추가로 AWS CLI, eksctl, kubectl, Helm을 아래 각 링크를 참고하여 설치한다.

- AWS CLI: https://docs.aws.amazon.com/cli/latest/userguide/getting-started-install.html

- eksctl: https://eksctl.io/installation/

- kubectl: https://docs.aws.amazon.com/eks/latest/userguide/install-kubectl.html

- Helm: https://helm.sh/docs/intro/install/

실습에 편리한 툴 중에서 jq 도 설치해보았다. macOS에서는 watch, tree 등을 brew로 설치하는 것도 좋다고 한다.

# Linux

sudo apt install -y tree jq

또한 아래 명령어를 실행하였을 때 VPC ID가 출력되는지 확인해본다.

aws ec2 describe-vpcs --filter 'Name=isDefault,Values=true' | jq '.Vpcs[0].VpcId'

만약 VPC ID가 출력되지 않는다면 아래 명령어를 실행하여 default VPC를 생성한다.

# default VPC를 생성

aws ec2 create-default-vpc

# default Subnet 생성

aws ec2 create-default-subnet --availability-zone ap-northeast-2a

aws ec2 create-default-subnet --availability-zone ap-northeast-2b

aws ec2 create-default-subnet --availability-zone ap-northeast-2c

aws ec2 create-default-subnet --availability-zone ap-northeast-2d

그리고 Visual Studio Code (줄여서 VSCode) 를 사용하는데, 이 때 본인은 WSL 환경에서 실습을 하고 있으므로, VSCode가 WSL 환경을 인지해야 한다. 이 부분은 WSL이라는 확장팩 설치 및 왼쪽 하단을 클릭하여 "Connect to WSL"을 실행하여 연결이 되어야 한다는 점을 참고하자.

또한 HashiCorp HCL 및 HashiCorp Terraform 확장을 설치하자.

1. Terraform 기본 사용

1.1. Terraform 기본 환경 및 사용해보기

먼저 아래와 같이 기본 환경을 준비해보자.

mkdir learn-terraform

cd learn-terraform

touch main.tf

그리고 Amazon Linux 2 최신 ami id를 찾아 AL2ID 환경변수에 저장해두자. "ami-0217b147346e48e84" 값을 얻을 수 있었다.

#aws ec2 describe-images --owners self amazon

aws ec2 describe-images --owners self amazon --query 'Images[*].[ImageId]' --output text

aws ec2 describe-images --owners amazon --filters "Name=name,Values=amzn2-ami-hvm-2.0.*-x86_64-gp2" "Name=state,Values=available"

aws ec2 describe-images --owners amazon --filters "Name=name,Values=amzn2-ami-hvm-2.0.*-x86_64-gp2" "Name=state,Values=available" --query 'Images|sort_by(@, &CreationDate)[-1].[ImageId, Name]' --output text

ami-0217b147346e48e84 amzn2-ami-hvm-2.0.20240412.0-x86_64-gp2

aws ec2 describe-images --owners amazon --filters "Name=name,Values=amzn2-ami-hvm-2.0.*-x86_64-gp2" "Name=state,Values=available" --query 'Images|sort_by(@, &CreationDate)[-1].[ImageId]' --output text

ami-0217b147346e48e84

AL2ID=`aws ec2 describe-images --owners amazon --filters "Name=name,Values=amzn2-ami-hvm-2.0.*-x86_64-gp2" "Name=state,Values=available" --query 'Images|sort_by(@, &CreationDate)[-1].[ImageId]' --output text`

echo $AL2ID

또한 EC2가 생성이 되는지 모니터링을 하는 명령어를 별도 터미널로 실행해두도록 하자.

# [터미널1] EC2 생성 모니터링

export AWS_PAGER=""

while true; do aws ec2 describe-instances --query "Reservations[*].Instances[*].{PublicIPAdd:PublicIpAddress,InstanceName:Tags[?Key=='Name']|[0].Value,Status:State.Name}" --filters Name=instance-state-name,Values=running --output text ; echo "------------------------------" ; sleep 1; done

테라폼 코드를 작성해보자. 아래 코드를 보면 provider와 resource 영역으로 나뉘어 있는데, provider는 Terraform으로 정의할 Infrastructure Provider를 의미하고, resource는 실제로 생성할 인프라 자원을 의미한다.

cat <<EOT > main.tf

provider "aws" {

region = "ap-northeast-2"

}

resource "aws_instance" "example" {

ami = "$AL2ID"

instance_type = "t2.micro"

}

EOT

이제 배포와 실행을 해 보도록 하자.

# 초기화

terraform init

ls -al

tree .terraform

# plan 확인

terraform plan

# apply 실행

terraform apply

Enter a value: yes 입력

# ec2 생성 확인 : aws 웹 관리 콘솔에서도 확인 - 서울 리전 선택

export AWS_PAGER=""

aws ec2 describe-instances --output table

# 테라폼 정보 확인

terraform state list

terraform show

terraform show aws_instance.example

이번에는 태그 정보를 수정하고 적용해보자.

cat <<EOT > main.tf

provider "aws" {

region = "ap-northeast-2"

}

resource "aws_instance" "example" {

ami = "$AL2ID"

instance_type = "t2.micro"

tags = {

Name = "aews-study"

}

}

EOT

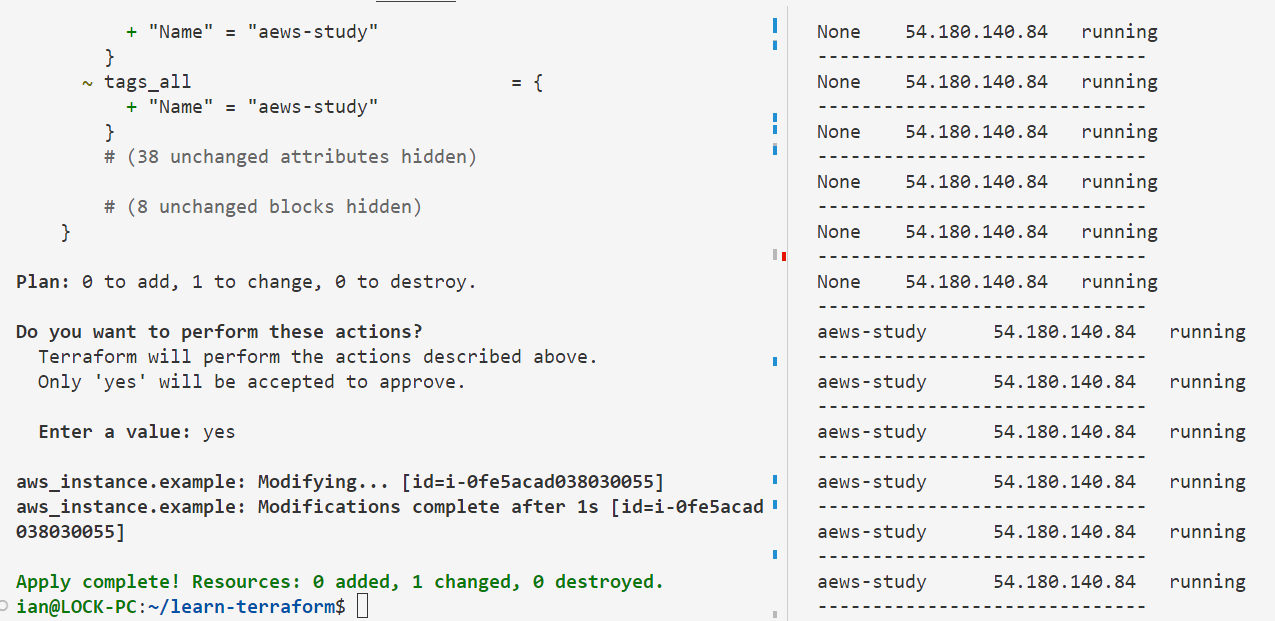

# plan 실행 시 아래와 같은 정보가 출력

terraform plan

# aws_instance.example will be updated in-place

~ resource "aws_instance" "example" {

id = "i-0fe5acad038030055"

~ tags = {

+ "Name" = "aews-study"

}

~ tags_all = {

+ "Name" = "aews-study"

}

# (38 unchanged attributes hidden)

# (8 unchanged blocks hidden)

}

Plan: 0 to add, 1 to change, 0 to destroy.

# apply 실행

terraform apply

Enter a value: yes 입력

# 모니터링 : [터미널1]에 Name 확인

실습을 완료하였으면 리소스를 삭제하자.

# 리소스 삭제

terraform destroy

Enter a value: yes 입력

혹은

terraform destroy -auto-approve

1.2. HCL 및 프로바이더, 변수 및 우선 순위 이해하기

그리고 Terraform을 잘 쓰기 위해서는 HCL에 대해 잘 이해하고 활용할 필요가 있겠다. https://github.com/hashicorp/hcl 또는 관련 내용을 찾아보고 충분히 학습하도록 하자.

몇 가지 실습을 더 해보았다. 프로바이더 버전을 과하게 높게 설정해보니 해당 프로바이더 버전을 찾을 수 없다는 오류를 확인할 수 있었다.

terraform {

required_version = ">= 1.0.0"

required_providers {

local = {

source = "hashicorp/local"

version = ">=10000.0.0"

}

}

}

resource "local_file" "abc" {

content = "123!"

filename = "${path.module}/abc.txt"

}

" >= 2.0.0"으로 수정한 이후 제대로 동작하는 결과를 확인할 수 있었다.

이와 같이 프로바이더, 리소스, 종속성, 리소스 속성 참조, 데이터 소스 구성, 데이터 소스 속성 참조, 변수 선언 방식 및 사용 등을 추가로 실습하여 확인해보았다.

그리고 변수 입력 방식과 우선순위도 스터디를 진행하였다. 변수를 선언하는 방식에 따라 변수 우선 순위가 있으므로 이를 적절히 사용한다면 로컬 환경과 빌드 서버 환경에서의 정의를 다르게 하거나, 프로비저닝 파이프라인을 구성하는 경우 외부 값을 변수에 저장할 수가 있다.

1.3. Terraform으로 AWS 네트워크 및 EC2 리소스 관리하기

이렇게 여러 가지 Terraform 기본을 살펴보았다면, 그 다음으로는 AWS에서 VPC 및 서브넷 등 상관관계가 있는 리소스에 대한 생성 및 관리를 Terraform에서 어떻게 이루어지는지 실습을 통해 확인해보는 과정을 진행하였다.

먼저 vpc.tf 라는 파일을 생성하여 배포해보자.

provider "aws" {

region = "ap-northeast-2"

}

resource "aws_vpc" "myvpc" {

cidr_block = "10.10.0.0/16"

tags = {

Name = "aews-study"

}

}

# 배포

terraform init && terraform plan && terraform apply -auto-approve

terraform state list

terraform state show aws_vpc.myvpc

# VPC 확인

export AWS_PAGER=""

aws ec2 describe-vpcs | jq

aws ec2 describe-vpcs --filter 'Name=isDefault,Values=false' | jq

aws ec2 describe-vpcs --filter 'Name=isDefault,Values=false' --output yaml

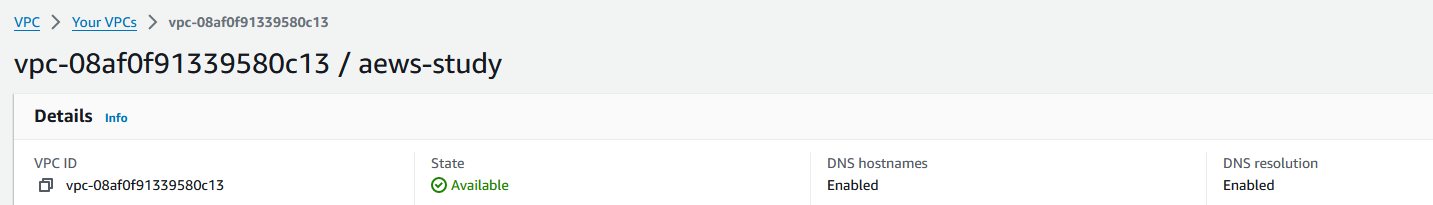

그 다음에는 VPC DNS 옵션을 수정한 후 배포를 해보자. 아래 코드에서 7번째 및 8번째 줄이 추가된 것이다.

provider "aws" {

region = "ap-northeast-2"

}

resource "aws_vpc" "myvpc" {

cidr_block = "10.10.0.0/16"

enable_dns_support = true

enable_dns_hostnames = true

tags = {

Name = "aews-study"

}

}

배포 이전

# 배포

terraform plan && terraform apply -auto-approve

배포 이후, DNS hostnames 및 DNS resolution 부분이 enabled 상태로 바뀐 것을 확인할 수 있다.

그 다음으로는 서브넷을 2개 추가해보자.

provider "aws" {

region = "ap-northeast-2"

}

resource "aws_vpc" "myvpc" {

cidr_block = "10.10.0.0/16"

enable_dns_support = true

enable_dns_hostnames = true

tags = {

Name = "aews-study"

}

}

resource "aws_subnet" "mysubnet1" {

vpc_id = aws_vpc.myvpc.id

cidr_block = "10.10.1.0/24"

availability_zone = "ap-northeast-2a"

tags = {

Name = "t101-subnet1"

}

}

resource "aws_subnet" "mysubnet2" {

vpc_id = aws_vpc.myvpc.id

cidr_block = "10.10.2.0/24"

availability_zone = "ap-northeast-2c"

tags = {

Name = "aews-subnet2"

}

}

output "aws_vpc_id" {

value = aws_vpc.myvpc.id

}

# 배포

terraform plan && terraform apply -auto-approve

terraform state list

aws_subnet.mysubnet1

aws_subnet.mysubnet2

aws_vpc.myvpc

terraform state show aws_subnet.mysubnet1

terraform output

terraform output aws_vpc_id

terraform output -raw aws_vpc_id

# graph 확인 > graph.dot 파일 선택 후 오른쪽 상단 DOT 클릭

terraform graph > graph.dot

# 서브넷 확인

aws ec2 describe-subnets --output text

# 참고 : aws ec2 describe-subnets --filters "Name=vpc-id,Values=vpc-<자신의 VPC ID>"

VPCID=$(terraform output -raw aws_vpc_id)

aws ec2 describe-subnets --filters "Name=vpc-id,Values=$VPCID" | jq

aws ec2 describe-subnets --filters "Name=vpc-id,Values=$VPCID" --output table

graph.dot 과 같이 생성되는 파일은 Graphviz Interactive Preview와 같은 VSCode extension 을 설치하면 아래 스크린샷과 같이 그래프 그림 형태로 확인할 수 있다.

그 다음에는 vpc.tf 코드 내용을 수정하여 IGW 인터넷 게이트웨이를 추가해보자.

provider "aws" {

region = "ap-northeast-2"

}

resource "aws_vpc" "myvpc" {

cidr_block = "10.10.0.0/16"

enable_dns_support = true

enable_dns_hostnames = true

tags = {

Name = "aews-study"

}

}

resource "aws_subnet" "mysubnet1" {

vpc_id = aws_vpc.myvpc.id

cidr_block = "10.10.1.0/24"

availability_zone = "ap-northeast-2a"

tags = {

Name = "aews-subnet1"

}

}

resource "aws_subnet" "mysubnet2" {

vpc_id = aws_vpc.myvpc.id

cidr_block = "10.10.2.0/24"

availability_zone = "ap-northeast-2c"

tags = {

Name = "aews-subnet2"

}

}

resource "aws_internet_gateway" "myigw" {

vpc_id = aws_vpc.myvpc.id

tags = {

Name = "aews-igw"

}

}

output "aws_vpc_id" {

value = aws_vpc.myvpc.id

}

# 배포

terraform plan && terraform apply -auto-approve

terraform state list

aws_internet_gateway.myigw

aws_subnet.mysubnet1

aws_subnet.mysubnet2

aws_vpc.myvpc

그 다음에는 vpc.tf 코드를 수정하여 IGW 인터넷 게이트웨이로 전달하는 디폴트 라우팅 정보를 추가하자.

provider "aws" {

region = "ap-northeast-2"

}

resource "aws_vpc" "myvpc" {

cidr_block = "10.10.0.0/16"

enable_dns_support = true

enable_dns_hostnames = true

tags = {

Name = "aews-study"

}

}

resource "aws_subnet" "mysubnet1" {

vpc_id = aws_vpc.myvpc.id

cidr_block = "10.10.1.0/24"

availability_zone = "ap-northeast-2a"

tags = {

Name = "aews-subnet1"

}

}

resource "aws_subnet" "mysubnet2" {

vpc_id = aws_vpc.myvpc.id

cidr_block = "10.10.2.0/24"

availability_zone = "ap-northeast-2c"

tags = {

Name = "aews-subnet2"

}

}

resource "aws_internet_gateway" "myigw" {

vpc_id = aws_vpc.myvpc.id

tags = {

Name = "aews-igw"

}

}

resource "aws_route_table" "myrt" {

vpc_id = aws_vpc.myvpc.id

tags = {

Name = "aews-rt"

}

}

resource "aws_route_table_association" "myrtassociation1" {

subnet_id = aws_subnet.mysubnet1.id

route_table_id = aws_route_table.myrt.id

}

resource "aws_route_table_association" "myrtassociation2" {

subnet_id = aws_subnet.mysubnet2.id

route_table_id = aws_route_table.myrt.id

}

resource "aws_route" "mydefaultroute" {

route_table_id = aws_route_table.myrt.id

destination_cidr_block = "0.0.0.0/0"

gateway_id = aws_internet_gateway.myigw.id

}

output "aws_vpc_id" {

value = aws_vpc.myvpc.id

}

# 배포

terraform plan && terraform apply -auto-approve

terraform state list

aws_internet_gateway.myigw

aws_route.mydefaultroute

aws_route_table.myrt

aws_route_table_association.myrtassociation1

aws_route_table_association.myrtassociation2

aws_subnet.mysubnet1

aws_subnet.mysubnet2

aws_vpc.myvpc

terraform state show aws_route.mydefaultroute

# graph 확인 > graph.dot 파일 선택 후 오른쪽 상단 DOT 클릭

terraform graph > graph.dot

# 라우팅 테이블 확인

#aws ec2 describe-route-tables --filters 'Name=tag:Name,Values=aews-rt' --query 'RouteTables[].Associations[].SubnetId'

aws ec2 describe-route-tables --filters 'Name=tag:Name,Values=aews-rt' --output table

그 다음에는 보안 그룹과 EC2 배포를 위한 sg.tf, ec2.tf 파일을 생성한다.

- sg.tf 파일 내용:

resource "aws_security_group" "mysg" {

vpc_id = aws_vpc.myvpc.id

name = "AEWS SG"

description = "AEWS Study SG"

}

resource "aws_security_group_rule" "mysginbound" {

type = "ingress"

from_port = 80

to_port = 80

protocol = "tcp"

cidr_blocks = ["0.0.0.0/0"]

security_group_id = aws_security_group.mysg.id

}

resource "aws_security_group_rule" "mysgoutbound" {

type = "egress"

from_port = 0

to_port = 0

protocol = "-1"

cidr_blocks = ["0.0.0.0/0"]

security_group_id = aws_security_group.mysg.id

}

# 배포

ls *.tf

terraform plan && terraform apply -auto-approve

terraform state list

aws_security_group.mysg

aws_security_group_rule.mysginbound

aws_security_group_rule.mysgoutbound

...

terraform state show aws_security_group.mysg

terraform state show aws_security_group_rule.mysginbound

# graph 확인 > graph.dot 파일 선택 후 오른쪽 상단 DOT 클릭

terraform graph > graph.dot

- ec2.tf 파일 내용:

data "aws_ami" "my_amazonlinux2" {

most_recent = true

filter {

name = "owner-alias"

values = ["amazon"]

}

filter {

name = "name"

values = ["amzn2-ami-hvm-*-x86_64-ebs"]

}

owners = ["amazon"]

}

resource "aws_instance" "myec2" {

depends_on = [

aws_internet_gateway.myigw

]

ami = data.aws_ami.my_amazonlinux2.id

associate_public_ip_address = true

instance_type = "t2.micro"

vpc_security_group_ids = ["${aws_security_group.mysg.id}"]

subnet_id = aws_subnet.mysubnet1.id

user_data = <<-EOF

#!/bin/bash

wget https://busybox.net/downloads/binaries/1.31.0-defconfig-multiarch-musl/busybox-x86_64

mv busybox-x86_64 busybox

chmod +x busybox

echo "Web Server</h1>" > index.html

nohup ./busybox httpd -f -p 80 &

EOF

user_data_replace_on_change = true

tags = {

Name = "aews-myec2"

}

}

output "myec2_public_ip" {

value = aws_instance.myec2.public_ip

description = "The public IP of the Instance"

}

#

ls *.tf

terraform plan && terraform apply -auto-approve

terraform state list

data.aws_ami.my_amazonlinux2

aws_instance.myec2

...

terraform state show data.aws_ami.my_amazonlinux2

terraform state show aws_instance.myec2

# 데이터소스 값 확인

terraform console

>

data.aws_ami.my_amazonlinux2.id

"ami-0972fbae82d8513f6"

data.aws_ami.my_amazonlinux2.image_id

data.aws_ami.my_amazonlinux2.name

data.aws_ami.my_amazonlinux2.owners

data.aws_ami.my_amazonlinux2.platform_details

data.aws_ami.my_amazonlinux2.hypervisor

data.aws_ami.my_amazonlinux2.architecture

exit

# graph 확인 > graph.dot 파일 선택 후 오른쪽 상단 DOT 클릭

terraform graph > graph.dot

# 출력된 EC2 퍼블릭IP로 cul 접속 확인

terraform output -raw myec2_public_ip

43.203.247.218

MYIP=$(terraform output -raw myec2_public_ip)

while true; do curl --connect-timeout 1 http://$MYIP/ ; echo "------------------------------"; date; sleep 1; done

AWS 리소스에 대한 의존성은 다음과 같다.

이와 같이 AWS EC2 리소스와 Security Group, 그리고 관련한 네트워크 리소스에 대한 전반적인 의존성을 확보하면서 Terraform으로 생성해보는 실습을 진행하였다. 실습을 다 진행한 후에는 리소스 삭제를 꼭 하자.

terraform destroy -auto-approve

1.4. 프로바이더 활용하기 - Tier

Terraform는 프로바이더에 대한 Tier (Official, Partner, Community) 가 있다. https://registry.terraform.io/browse/providers 에서는 Official은 Hashicorp에서 직접 유지보수를 하는 Tier, Partner는 기술 파트너를 통해 유지보수가 이루어지는 Tier, Community는 Hashicorp 커뮤니티 생태계를 통해 퍼블리싱 및 유지보수가 이루어진다고 한다.

https://registry.terraform.io/providers/hashicorp/aws/latest 링크를 통해 aws provider 버전을 확인해보았다. 현재 5.47.0으로 Hashicorp에서 직접 유지보수하는 Official Tier에 해당하였다.

1.5. 프로바이더 활용 및 모듈화

Terraform에서 프로바이더를 잘 활용하기 위한 내용으로 다음을 살펴보았다.

- 로컬 이름과 프로바이더 지정: 같은 이름에 해당하는 프로바이더에 대해 다른 로컬 이름을 부여하여 사용할 수 있다. 다음은 동일한 http 접두사를 사용하는 다수 프로바이더를 적용하는 예시이다.

terraform {

required_providers {

architech-http = {

source = "architect-team/http"

version = "~> 3.0"

}

http = {

source = "hashicorp/http"

}

aws-http = {

source = "terraform-aws-modules/http"

}

}

}

data "http" "example" {

provider = aws-http

url = "https://checkpoint-api.hashicorp.com/v1/check/terraform"

request_headers = {

Accept = "application/json"

}

}

- 단일 프로바이더의 다중 정의: 동일한 프로바이더를 사용하지만 다른 조건을 갖는 경우, 사용되는 리소스마다 별도로 선언된 프로바이더를 지정해야 하는 경우가 있다. 아래 예제는 리전을 다르게 구성한 AWS 프로바이더를 aws_instance에 지정하는 방법이다.

provider "aws" {

region = "ap-southeast-1"

}

provider "aws" {

alias = "seoul"

region = "ap-northeast-2"

}

resource "aws_instance" "app_server1" {

ami = "ami-06b79cf2aee0d5c92"

instance_type = "t2.micro"

}

resource "aws_instance" "app_server2" {

provider = aws.seoul

ami = "ami-0ea4d4b8dc1e46212"

instance_type = "t2.micro"

}

#

terraform init && terraform plan

terraform apply -auto-approve

#

terraform state list

echo "aws_instance.app_server1.public_ip" | terraform console

echo "aws_instance.app_server2.public_ip" | terraform console

aws ec2 describe-instances --filters Name=instance-state-name,Values=running --output table

aws ec2 describe-instances --filters Name=instance-state-name,Values=running --output table --region ap-southeast-1

# 삭제

terraform destroy -auto-approve

- 프로바이더 요구사항 정의: 프로바이더 요구사항은 terraform 블록의 required_providers 블록에 여러 개를 정의할 수 있다. 다음과 같은 형식으로 요구사항 정의 블록을 사용하며, 호스트 주소, 네임스페이스, 유형 파트를 참고하자.

terraform {

required_providers {

<프로바이더 로컬 이름> = {

source = [<호스트 주소>/]<네임스페이스>/<유형>

version = <버전 제약>

}

...

}

}1.5. 모듈

시간이 지날수록 구성이 복잡해지고 관리하는 리소스가 늘어나게 되기에 모듈화를 통해 관리하는 것이 좋다. 하나의 프로비저닝에서 사용자와 패스워드를 여러 번 구성해야 하는 경우를 가상의 시나리오로 삼아 모듈화를 진행하는 실습을 진행해보았다.

- random_pet는 이름을 자동으로 생성하고, random_password는 사용자의 패스워드를 설정한다 - random_pet

- random_password는 random 프로바이더 리소스로 난수 형태로 패스워드를 만들 수 있다.

먼저 terraform-random-pwgen 모듈을 만들어보자. 디렉터리를 하나 새로 만들고 06-module-traning/modules/terraform-random-pwgen/main.tf variable.tf output.tf 파일을 만든다.

mkdir -p 06-module-traning/modules/terraform-random-pwgen

# main.tf

resource "random_pet" "name" {

keepers = {

ami_id = timestamp()

}

}

resource "random_password" "password" {

length = var.isDB ? 16 : 10

special = var.isDB ? true : false

override_special = "!#$%*?"

}# variable.tf

variable "isDB" {

type = bool

default = false

description = "패스워드 대상의 DB 여부"

}# output.tf

output "id" {

value = random_pet.name.id

}

output "pw" {

value = nonsensitive(random_password.password.result)

}

#

cd 06-module-traning/modules/terraform-random-pwgen

#

ls *.tf

terraform init && terraform plan

# 테스트를 위해 apply 시 변수 지정

terraform apply -auto-approve -var=isDB=true

Apply complete! Resources: 2 added, 0 changed, 0 destroyed.

Outputs:

id = "knowing-aardvark"

pw = "Y5eeP0i2KLLE9gBa"

# 확인

terraform state list

terraform state show random_pet.name

terraform state show random_password.password

# graph 확인

terraform graph > graph.dot

자식 모듈 호출을 실습해본다. 다수 리소스를 같은 목적으로 여러 번 반복해서 사용하려면 리소스 수만큼 반복해 구성 파일을 정의해야 하고 이름도 고유하게 설정해줘야 하는 부담이 있지만, 모듈을 활용하면 반복되는 리소스 묶음을 최소화할 수 있다.

mkdir -p 06-module-traning/06-01-basic

# 06-01-basic/main.tf

module "mypw1" {

source = "../modules/terraform-random-pwgen"

}

module "mypw2" {

source = "../modules/terraform-random-pwgen"

isDB = true

}

output "mypw1" {

value = module.mypw1

}

output "mypw2" {

value = module.mypw2

}

#

cd 06-module-traning/06-01-basic

#

terraform init && terraform plan && terraform apply -auto-approve

Apply complete! Resources: 2 added, 0 changed, 0 destroyed.

Outputs:

mypw1 = {

"id" = "on-mammal"

"pw" = "3EzelOixyR"

}

mypw2 = {

"id" = "brave-bull"

"pw" = "KS%jBcA*dpI$p6*0"

}

# 확인

terraform state list

# tfstate에 모듈 정보 확인

cat terraform.tfstate | grep module

# terraform init 시 생성되는 modules.json 파일 확인

tree .terraform

.terraform

├── modules

│ └── modules.json

...

## 모듈로 묶여진 리소스는 module이라는 정의를 통해 단순하게 재활용하고 반복 사용할 수 있다.

## 모듈의 결과 참조 형식은 module.<모듈 이름>.<output 이름>으로 정의된다.

cat .terraform/modules/modules.json | jq

{

"Modules": [

{

"Key": "",

"Source": "",

"Dir": "."

},

{

"Key": "mypw1",

"Source": "../modules/terraform-random-pwgen",

"Dir": "../modules/terraform-random-pwgen"

},

{

"Key": "mypw2",

"Source": "../modules/terraform-random-pwgen",

"Dir": "../modules/terraform-random-pwgen"

}

]

}

# graph 확인

terraform graph > graph.dot

2. Terraform으로 EKS 배포

첫 번째 EKS 클러스터를 배포해보자. EKS Module (링크: https://registry.terraform.io/modules/terraform-aws-modules/eks/aws/20.8.5 )를 사용한다.

# 코드 가져오기

git clone https://github.com/gasida/aews-cicd.git

cd aews-cicd/4

# terraform 환경 변수 저장

export TF_VAR_KeyName=[각자 ssh keypair]

export TF_VAR_KeyName='kp-ian'

echo $TF_VAR_KeyName

#

terraform init

terraform plan

# 10분 후 배포 완료

terraform apply -auto-approve

약 10분이 지나 배포가 완료되면 배포 정보를 확인한다. kubectl 명령어를 실행 가능하도록 인증 정보를 가져오는 단계가 필요하다.

#

kubectl get node -v=6

# EKS 클러스터 인증 정보 업데이트

CLUSTER_NAME=myeks

aws eks update-kubeconfig --region ap-northeast-2 --name $CLUSTER_NAME

kubectl config rename-context "arn:aws:eks:ap-northeast-2:$(aws sts get-caller-identity --query 'Account' --output text):cluster/$CLUSTER_NAME" "Aews-Labs"

#

kubectl cluster-info

kubectl get node --label-columns=node.kubernetes.io/instance-type,eks.amazonaws.com/capacityType,topology.kubernetes.io/zone

kubectl get pod -A

기타 설치도 진행하자.

# ExternalDNS

MyDomain=<자신의 도메인>

MyDomain=sdndev.link

MyDnzHostedZoneId=$(aws route53 list-hosted-zones-by-name --dns-name "${MyDomain}." --query "HostedZones[0].Id" --output text)

echo $MyDomain, $MyDnzHostedZoneId

curl -s -O https://raw.githubusercontent.com/gasida/PKOS/main/aews/externaldns.yaml

MyDomain=$MyDomain MyDnzHostedZoneId=$MyDnzHostedZoneId envsubst < externaldns.yaml | kubectl apply -f -

# kube-ops-view

helm repo add geek-cookbook https://geek-cookbook.github.io/charts/

helm install kube-ops-view geek-cookbook/kube-ops-view --version 1.2.2 --set env.TZ="Asia/Seoul" --namespace kube-system

kubectl patch svc -n kube-system kube-ops-view -p '{"spec":{"type":"LoadBalancer"}}'

kubectl annotate service kube-ops-view -n kube-system "external-dns.alpha.kubernetes.io/hostname=kubeopsview.$MyDomain"

echo -e "Kube Ops View URL = http://kubeopsview.$MyDomain:8080/#scale=1.5"

# AWS LB Controller

helm repo add eks https://aws.github.io/eks-charts

helm repo update

helm install aws-load-balancer-controller eks/aws-load-balancer-controller -n kube-system --set clusterName=$CLUSTER_NAME \

--set serviceAccount.create=false --set serviceAccount.name=aws-load-balancer-controller

# gp3 스토리지 클래스 생성

kubectl apply -f https://raw.githubusercontent.com/gasida/PKOS/main/aews/gp3-sc.yaml

Kube Ops까지 잘 나오는 것을 확인하였다.

그 다음 코드를 재사용하여 두 번째 클러스터를 배포해보자. 다른 클러스터에 접근하므로 서로 다른 kubeconfig 가 필요하다. myeks 클러스터에 접근할 때는 디폴트 config를, myeks2 클러스터에 접근할 때는 myeks2config 파일을 참조하는 것으로 확인을 하였다.

#

cd ..

mkdir 5

cd 5

cp ../4/*.tf .

ls

#

terraform init

terraform apply -auto-approve -var=ClusterBaseName=myeks2 -var=KubernetesVersion="1.28"

# EKS 클러스터 인증 정보 가져오기

CLUSTER_NAME2=myeks2

aws eks update-kubeconfig --region ap-northeast-2 --name $CLUSTER_NAME2 --kubeconfig ./myeks2config

# EKS 클러스터 정보 확인

kubectl --kubeconfig ./myeks2config get node

kubectl --kubeconfig ./myeks2config get pod -A

실습을 다 하였다면 첫 번째 클러스터 및 두 번째 클러스터를 아래를 참고하여 완전히 삭제하도록 하자. 첫 번째 클러스터를 삭제하고

# CLB는 terraform으로 배포하지 않고 직접 수동으로 배포되었으니, 수동으로 삭제를 해주어야 함

helm uninstall kube-ops-view --namespace kube-system

# 클러스터 삭제

terraform destroy -auto-approve

두 번째 클러스터도 삭제한다.

# 클러스터 삭제

terraform destroy -auto-approve -var=ClusterBaseName=myeks2 -var=KubernetesVersion="1.28"

'Amazon EKS (Elastic Kubernetes Service)' 카테고리의 다른 글

| [AEWS] 스터디 7주차 - EKS CI/CD (0) | 2024.04.15 |

|---|---|

| [AEWS] 스터디 6주차 - EKS Security (0) | 2024.04.14 |

| [AEWS] 스터디 5주차 - EKS Autoscaling (0) | 2024.04.07 |

| [AEWS] 스터디 4주차 - Observability (0) | 2024.03.31 |

| [AEWS] 스터디 3주차 - EKS Storage & Nodegroup (0) | 2024.03.24 |